會員登入

加入TCA

人才招募

站內搜尋

|

|

下一則 |

| 回列表頁 | |

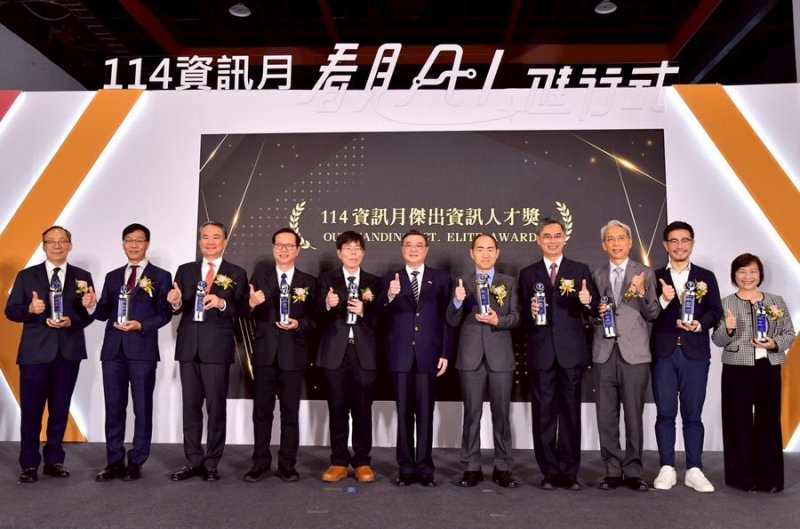

行政院長卓榮泰頒發114年傑出資訊人才獎

|

2025資訊月數發部數產署主題館「moda AI LIVING LAB」熱鬧開幕

|

行政院長卓榮泰慶賀InnoVEX十周年

|

數發部政次林宜敬(中)頒發獨立遊戲開發獎勵暨產品化加值計畫獎項

|

全力支持新創 本會何春盛常務理事出席InnoVEX 2024 Night Party

|

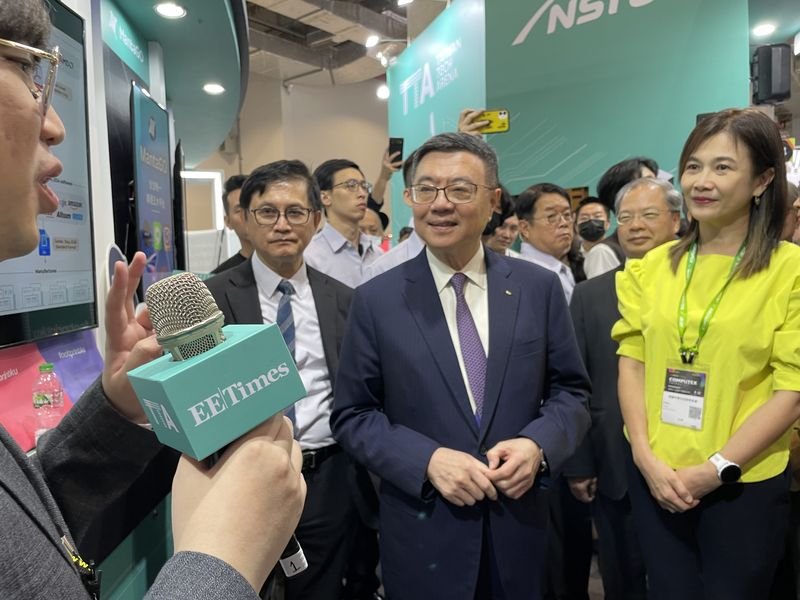

行政院長卓榮泰參訪2024 InnoVEX

|