2025 未來科技獎亮點技術系列報導 - 邊緣運算最佳選擇:高效能端對端大型語言模型加速器晶片

在全球AI浪潮推動下,大型語言模型(LLM)已廣泛應用於日常與專業領域,半導體晶片更成為驅動科技進步的核心引擎,而當企業伺服器或手機等行動裝置,要能提供即時推理服務,同時降低能源消耗並保障資料隱私。未來人人可在手機上離線運行LLM,實現隨時隨地安全互動的AI體驗,國立陽明交大黃俊達教授團隊研發出針對邊緣運算應用優化之大型語言模型推論加速器晶片,將是最佳選擇。

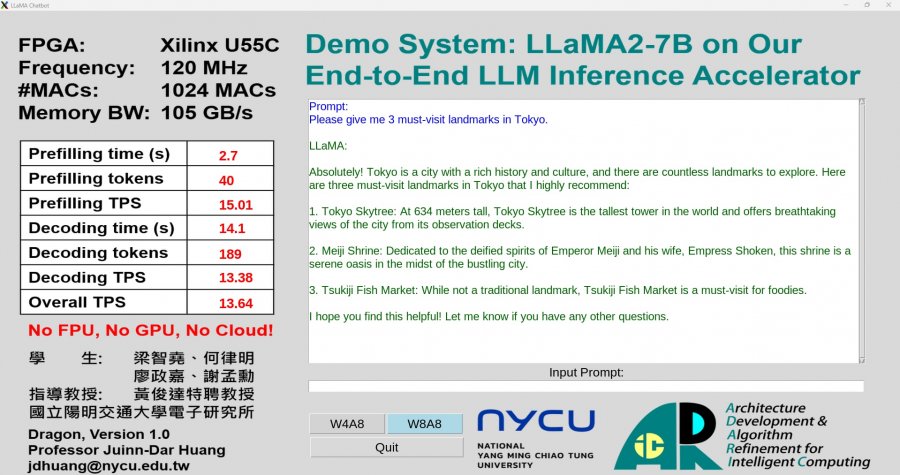

這顆針對邊緣運算進行優化之的高效能端對端大型語言模型加速器晶片,是專為Transformer架構與LLM推論優化的「矩陣乘法加速器(MMA )」。,實現10TOPS的高運算力,並可獨立完成推論過程中99.9%的計算;同時支援先進的混合精度計算技術,在每秒100GB記憶體頻寬下進行大型語言模型(Meta LLaMA2-7B)推論,每秒可產生高達24個詞元(token),展現出卓越推論效能與競爭力。

晶片內建MX運算與動態量化單元,有效提升能效與精度。支援多種精度格式與非線性函數,優化資料傳輸,大幅降低延遲。執行Llama2-7b時運算資源使用率達95%,PPL表現僅與原模型差0.3,為目前唯一實現LLM端對端計算的設計。由於晶片具備低功耗、高效能等優勢,是目前唯一可全端運行大語言模型於邊緣裝置的方案。相較於喬治亞理工的MicroScopiQ、首爾大學的Tender及高麗大學的OPAL架構,率先實現LLM on Edge的完整落地。

「高效能端對端大型語言模型加速器晶片」將在10月16日舉辦的台灣創新技術博覽會未來科技館展出,團隊會將設計的電路,燒入可編程的加速器晶片(FPGA),利用電腦連線到加速器,使用者將可以在現場利用設計的軟體,輸入任何問題,經過我們的加速器運算後及時產生回答,展示加速器系統除了在低精度運行的同時,還能維持其運算準確度與速度。

歡迎有興趣產學合作、技轉者,請聯繫李小姐wanting@mail.tca.org.tw│25774249 ext.973或線上預約一對一媒合服務,我們將竭誠為您安排安排導覽時間、一對一商洽等。

(發佈時間:2025-09-03)